Назад в будущее: как исследования из 80-х повлияли на нейросети, которые мы знаем

Месяц назад, 8 октября, Нобелевскую премию по физике присудили двум ученым. Оба Нобелиата исследовали механизмы обучения и математические принципы, лежащие в основе нейронных сетей. Джон Хопфилд разработал «Сеть Хопфилда», способную хранить и восстанавливать информацию. Она работает по принципу ассоциативной памяти — система может запоминать различные шаблоны и воспроизводить их даже при наличии искажений или неполных данных.

Другой лауреат, Джеффри Хинтон, предложил методы, которые позволяют нейронным сетям самостоятельно находить закономерности в данных. Они стали основой для современных крупных нейронных сетей, которые сегодня помогают компьютерам решать задачи, ранее доступные только человеку: перевод текста, анализ изображений, ведение диалогов.

В заметке расскажем, как открытия прошлого века повлияли на машинное обучение в будущем. Михаил Захаров, кандидат физико-математических наук, ведущий менеджер продукта в YADRO, поможет разобраться, в чем сложность сети Хопфилда и почему масштабирование системы случилось только спустя десятилетия.

Мозг в основе всего

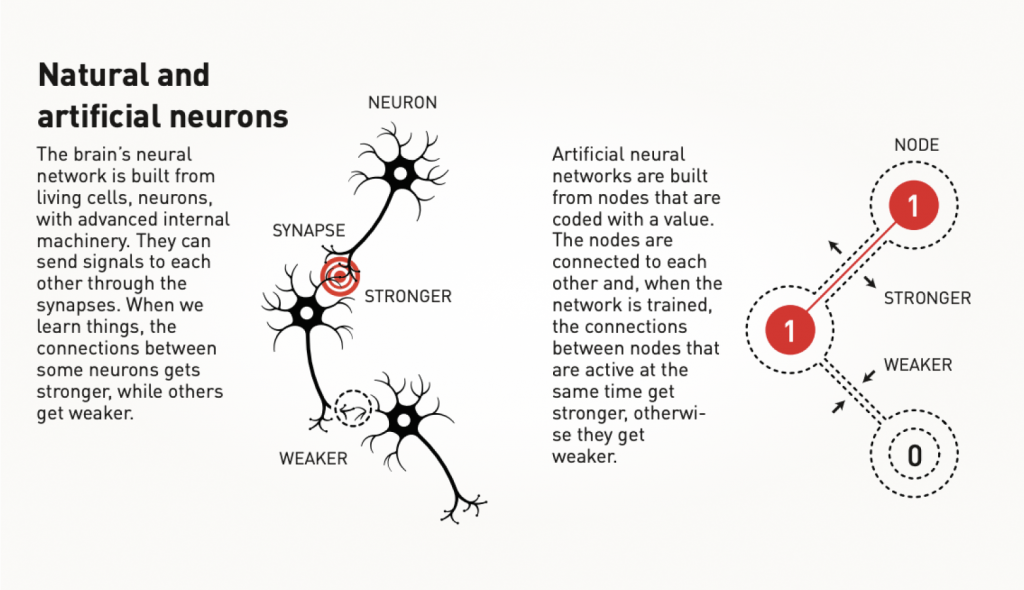

Нейронные сети так называются не просто так. Они созданы по аналогии с биологическими нейронными сетями. В мозге нейроны передают информацию через электрические и химические сигналы по синапсам.

В 1949 году Дональд Хебб, канадский физиолог и нейропсихолог, предложил принцип, известный как «правило Хебба»: если два нейрона активно работают одновременно, связь между ними усиливается. В искусственных сетях нейроны имитируются узлами, а связи между ними (синапсы) моделируются весами, которые изменяются в процессе обучения.

В конце 1960-х многие исследователи сомневались в реальном применении нейронных сетей. Однако интерес к искусственным нейронным сетям возродился в 1980-х годах, когда были предложены несколько важных идей, включая работы нынешних лауреатов.

Как работает принцип ассоциативной памяти

В 1980-х годах Джон Хопфилд, американский физик и нейробиолог, перешел из Принстонского университета в Калифорнийский технологической институт. В последнем ему предложили работать профессором химии и биологии и предоставили ресурсы для экспериментов и развития нейронных сетей.

Хопфилд описал архитектуру нейросетей с помощью физических моделей. Ученый изучал магнитные материалы, где каждый атом ведет себя как крошечный магнит из-за своего атомного спина. В магнитных материалах, особенно в спиновых стеклах, система может находиться в различных энергетических состояниях, и ее стабильные состояния соответствуют локальным минимумам энергии.

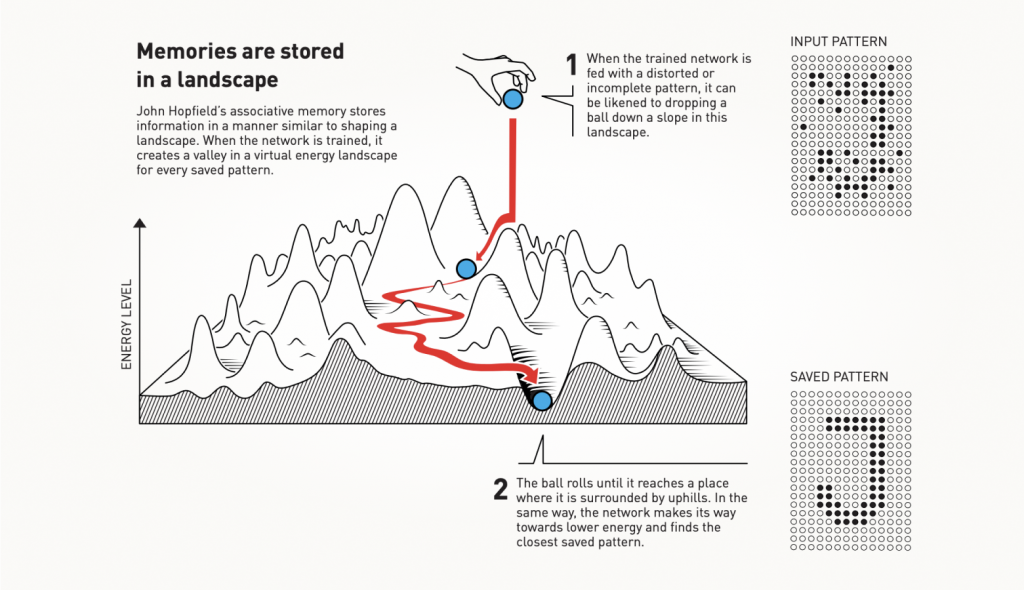

Аналогично, сеть Хопфилда имеет энергетическую функцию, которая характеризует ее состояние, и сеть стабилизируется, когда достигает локального минимума энергии. Как и в магнетизме, сеть стремится перейти в состояние с наименьшей энергией, что позволяет ей «вспоминать» один из ранее выполненных паттернов. Ассоциативная память называется так потому, что она способна восстанавливать полную информацию по ее части. Точно так работают ассоциации для памяти человека.

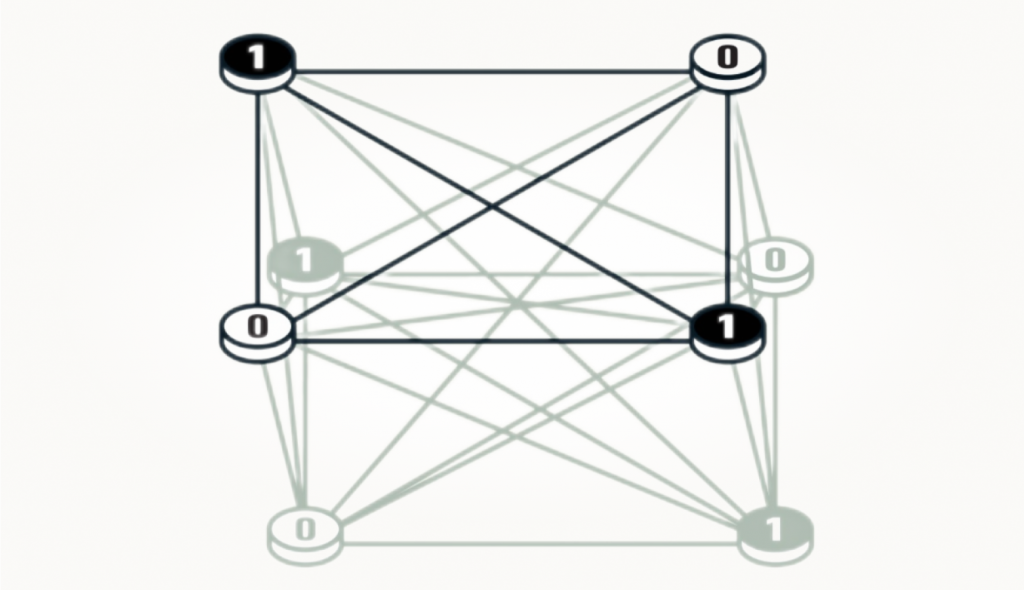

Хопфилд предложил описывать состояние сети с помощью функции энергии, которая зависит от всех значений узлов и сил связей между ними. Энергия минимальна, когда сеть находится в одном из обученных состояний (паттернов). Для обучения сети подают входные данные — изображение, которое закодировано бинарно: черный пиксель соответствует значению 0, а белый — 1. Сеть Хопфилда запоминает это изображение, настраивая связи между нейронами по специальной формуле, чтобы сохранить паттерн с минимальной энергией.

Когда сеть получает искаженное или новое изображение, происходит обновление узлов. Они перебираются один за другим, для каждого проверяется, приведет ли изменение его значения к снижению энергии всей сети.

Например, если текущий пиксель черный (0), но при его изменении на белый (1) энергия сети снизится, то он меняет свое значение на 1. И так для всех узлов.

Процесс продолжается до тех пор, пока найти изменения, которые привели бы к дальнейшему снижению энергии сети, будет невозможно. В этот момент сеть достигает состояния стабилизации.

Когда сеть стабилизируется, она часто воспроизводит оригинальное изображение, заложенное в процессе обучения. То есть сеть вспоминает один из сохраненных паттернов на основе принципа минимизации энергии.

Сложность сетей Хопфилда была в их ограниченной способности к масштабированию. Несмотря на успехи, модель не могла работать с большими объемами данных. Потребовались десятилетия, чтобы вычислительные возможности устройств догнали теоретические достижения.

Когда Хопфилд в 1982 году представил свою работу по ассоциативной памяти, его идеи задали новый вектор в развитии искусственных нейронных сетей. Ключевой момент его подхода: сеть могла хранить и восстанавливать данные на основе узлов, связанных между собой. Каждый узел мог принимать определенное значение, и за счет многократных взаимодействий между ними сеть сама находила оптимальное состояние. Это стало ранним примером того, что позже назвали машинным обучением.

Открытие Джеффри Хинтона

Машинное обучение отличается от традиционного программирования, где данные обрабатываются по заранее заданным инструкциям. Вместо этого в системах машинного обучения компьютер обучается на, как правило, большой базе примеров. Это позволяет ему решать более сложные задачи, например, распознавать объекты на изображениях.

В 1985 Джеффри Хинтон, британский и канадский ученый, вдохновленный работами Хопфилда, также задался вопросом, можно ли использовать принципы физики для создания более сложных сетей. Его идея заключалась в том, чтобы интегрировать методы статистической физики. Это позволило бы нейросети не только хранить информацию, но и генерировать новые данные. Так была создана Машина Больцмана — один из ключевых элементов ранней эры генеративных моделей.

Машина Больцмана, в отличие от сети Хопфилда, оперировала двумя уровнями: видимыми и скрытыми узлами. Это сделало систему более гибкой и мощной, так как скрытые узлы позволяли системе находить внутренние зависимости в данных, которые могли быть недоступны на поверхности.

Важным достижением Машины Больцмана стала ее способность обучаться без прямых инструкций: достаточно было показать сети примеры, и она начинала распознавать паттерны в новых данных. Эта революция в области машинного обучения открыла путь тому, что мы сегодня называем глубоким обучением.

В 2018 году Хинтон получил аналог Нобелевской премии, только в области информатики — премию Тьюринга.

Нейросети сегодня

Сегодня идеи Хопфилда и Хинтона нашли воплощение в современных глубоких нейронных сетях, которые используются повсеместно — от систем рекомендаций фильмов на стриминговых платформах до анализа медицинских данных. Масштаб современных сетей поразителен: если в 1982 году Хопфилд работал с сетью из 30 узлов, то сегодня речь идет о миллиардах и даже триллионах параметров.

Современные методы машинного обучения значительно улучшились по сравнению с первоначальными моделями. Узлы могут хранить не только бинарные значения (черное или белое), но и более сложные данные, что расширяет возможности сетей.

Хопфилд и Хинтон показали, что физические подходы могут быть полезны в решении задач по обработке данных и что обучение на основе примеров — ключевой шаг к созданию машин, которые могут «думать», как люди.