Вундервафля для искусственного интеллекта: что внутри самого большого чипа Wafer-Scale Engine

Стартап Cerebras представил третье поколение мегачипов WSE, спроектированных под задачи искусственного интеллекта. На огромной, в сравнении с площадью одного классического CPU, кремниевой подложке разместилось 4 триллиона транзисторов. Со стороны такая «система на пластине» напоминает локальные эксперименты по изготовлению самого большого блина или яблочного пирога — для попадания в новости и Книгу рекордов Гиннеса. Но разработка компании Cerebras — не просто праздная, бессмысленная на поверку забава.

Что за начинка у этой «вундервафли» и какие перспективы она открывает для обучения моделей искусственного интеллекта, рассказываем в заметке.

Процессор на всю кремниевую пластину

Первое, о чем думаешь, смотря на новую систему Wafer-Scale Engine 3, это, конечно, о ее размере. Площадь пластины составляет 46,225 мм², и, в отличие от многих других процессоров, этот чип не удержать между двумя пальцами.

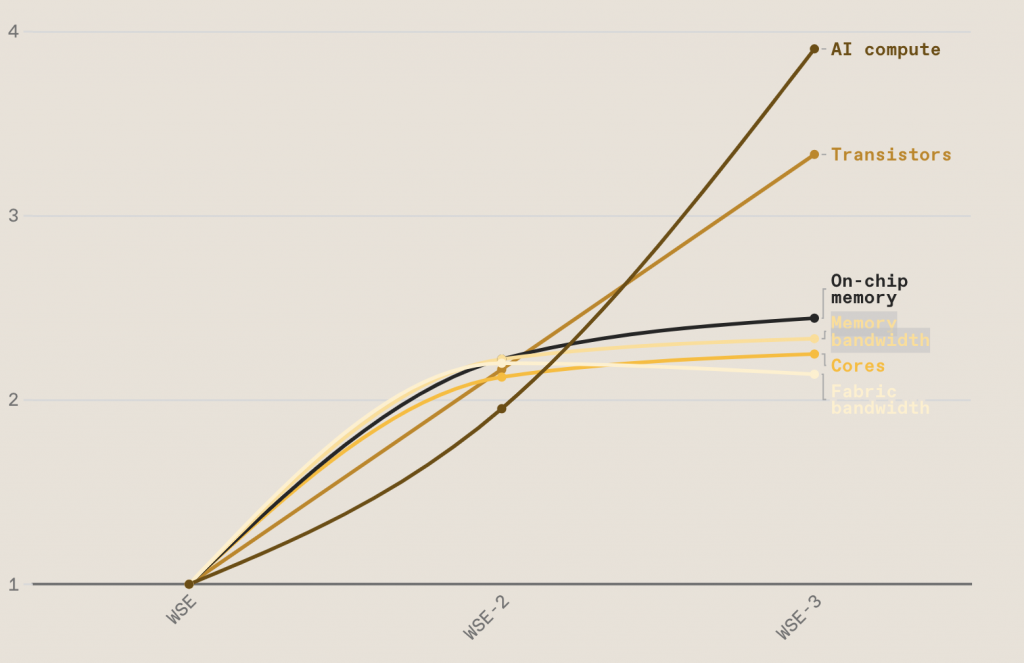

Впрочем, размер — не новшество для Cerebras System, стартапа, чья основная цель — ускорить работу генеративного ИИ с помощью нового класса суперкомпьютеров для AI-задач. Разрабатывать процессоры масштаба кремниевой пластины компания начала еще 8 лет назад. И первый «Колосс» — дебют Wafer-Scale Engine на рынке — вышел в 2019 году. За прошедшее время площадь кристалла не менялась, но, не предавая закон Мура, каждое новое поколение отличается экспоненциальным ростом числа размещенных на нем транзисторов. Если на первом чипе, произведенном по 16-нм техпроцессу, было 1,2 триллиона транзисторов, то WSE-3, в котором перешли на 5-нм техпроцесс, уместил в себе рекордные 4 триллиона.

В таблице выше можно заметить, что число транзисторов — практически единственный показатель, который ощутимо вырос с момента релиза WSE-2. Объем статической памяти с произвольным доступом (SRAM), пропускная способность памяти и интерконнекта выросли незначительно.

Ядра WSE-3 заточены под работу с искусственным интеллектом. В третьем поколении микроархитектуры SLAC-ядра (Sparse Linear Algebra Compute Core) стали слоеным пирогом, эффективно и быстро решающим операции над разреженными матрицами (база для нейронных сетей).

У каждого из ядер WSE-3 теперь есть 8-Wide FP16 SIMD-блок — вдвое шире, чем у ядер прошлого поколения. SIMD (Single Instruction, Multiple Data) — это технология параллельных вычислений, которая позволяет одновременно выполнять одну операцию над несколькими потоками данных.

Неделимое целое

Обычно процессоры изготавливаются путем печати множества копий одного чипа на пластине из кремния. Затем она «разрезается» на отдельные процессоры. Для многих систем одного-двух процессоров будет достаточно, но только не для задач глубокого обучения. Чтобы масштабировать и ускорять обучение моделей искусственного интеллекта, инженеры программируют ML-кластеры из графических ускорителей, затрачивая на это десятки, иногда сотни рабочих часов. Только представьте: для обучения модели из 3 млрд параметров в течение 5 дней потребуется 400 GPU! И создание подобного ML-кластера — нетривиальная задача, требующая работы со сложной иерархией объемов памяти отдельных процессоров, их пропускной способностью, топологией межсоединений и синхронизации.

Конструируя WSE, компания Cerebras пришла к интересной мысли: зачем резать пластину, если в итоге ее вновь придется «склеивать»?

В итоге инженеры пошли ва-банк и использовали максимально возможную по размеру 300-мм подложку из кремния для размещения чипа с параметрами 215×215 мм. Чтобы вписать такой квадрат, понадобилось закруглить углы пластины. В реализации амбициозного проекта Cerebras помогла известная тайваньская компания по производству полупроводников TSMC.

Производить чипы размером с кремниевую пластину очень сложно, в том числе из-за высоких рисков получения «бракованных» кристаллов на подложке. Чтобы подстраховать себя, инженеры Cerebras добавили 1−1,5% резервных ядер ИИ, которые могут подменить дефектные. Как именно и где расположены резервные ядра, компания не раскрывает.

Самый быстрый чип в мире для решения задач искусственного интеллекта

Поскольку основная цель WSE-3 — вывести вычисления для ИИ на новый уровень, неудивительно, что чип сравнивают с самым крупным на данный момент графическим ускорителем — Nvidia H100.

Такой конкуренции один GPU, конечно, не выдерживает — хотя бы по размерам: мегачип WSE-3 в 57 раз крупнее «малыша» от Nvidia, размещенного на площади 814 мм². Cerebras подсчитала, что графические процессоры не смогут догнать WSE-3 в течение минимум шести лет.

Сравнение стоимости обеих систем компания, однако, обходит стороной, ведь производство чипа размером с кремниевую подложку оценивается в несколько миллионов долларов. Расчетов стоимости создания ML-кластера подобной мощности также нет, поэтому говорить о выгодности и целесообразности приобретения WSE-3 пока нельзя.

В любом случае, WSE-3 подкупает перспективами всех, кто готов много инвестировать в развитие ИИ. Мегачип может обучать модели с 24 триллионами параметров, а таких запросов пока просто не существует. Одна из крупнейших LLM Llama2−70B использует «всего лишь» 70 миллиардов параметров.

Куда может быть встроен чип

Очевидно, что процессор с таким форм-фактором, не встроить в стандартную материнскую плату. WSE разрабатывается специально для AI-кластеров производства Cerebras — систем СS.

С огромной системой памяти до 1,2 петабайт CS-3 предназначен для обучения моделей искусственного интеллекта следующего поколения, которые превышают в сложности и объемах «челленджевые» GPT-4 и Gemini. Модели с 24 трлн параметров могут храниться в одном пространстве логической памяти без разделения и рефакторинга, и это очевидно ускоряет производимые вычисления.

В планах Cerebras — создать девять суперкомпьютеров в разных частях мира. Две первые системы собрали в прошлом году, в их основе — CS-2 с совокупной производительностью 4 экзафлопса. Несколько месяцев назад компания сообщила о создании третьего из девяти запланированных суперкомпьютеров. Condor Galaxy 3, который строят в Далласе (Техас), основан как раз на третьем поколении систем CS. Они же станут технологической базой остальных суперкомпьютеров, которые компания обещала выпустить до конца 2024 года.